情報ガイドステーションメニュー

| IPU

| IPU

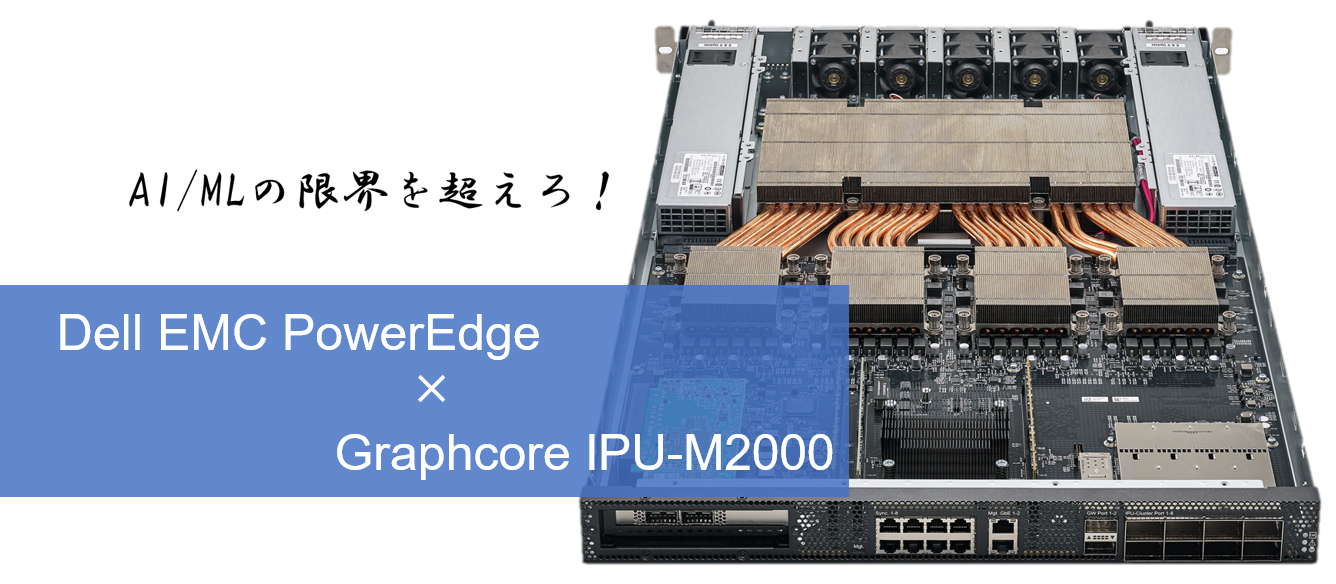

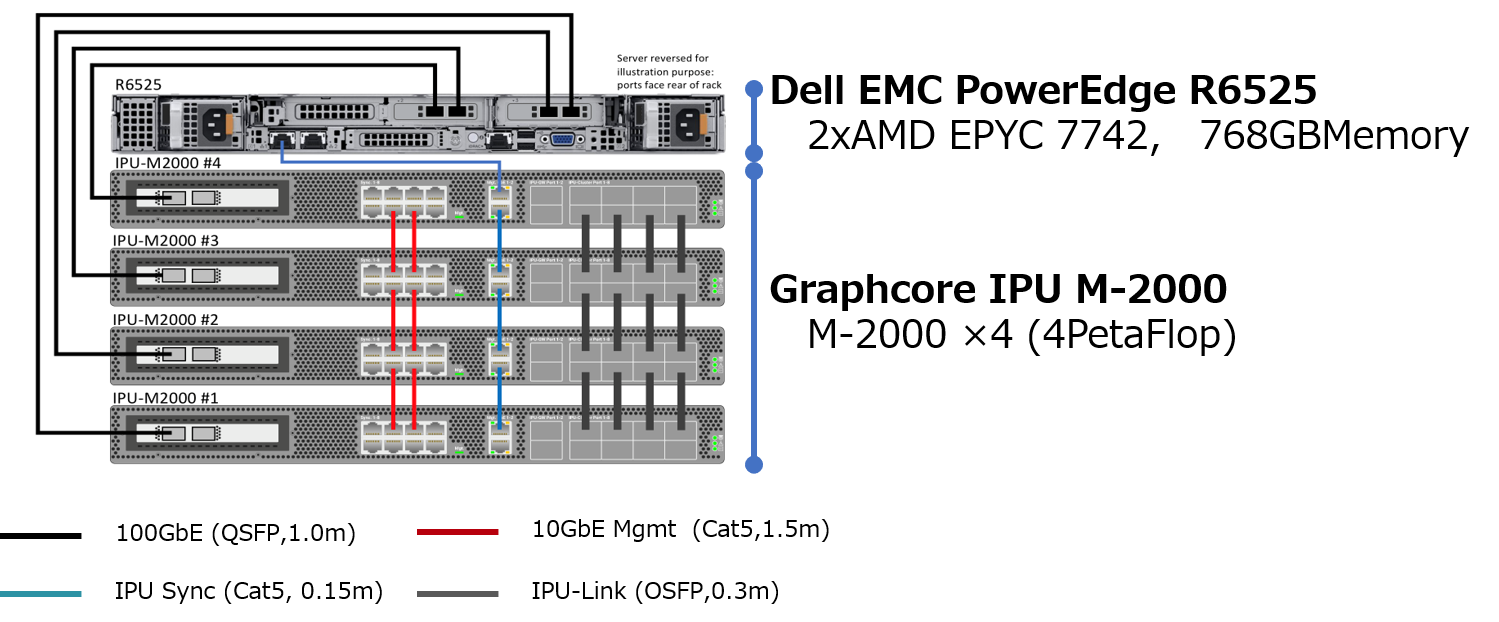

AIインフラストラクチャの新しいコアとなるIPU-M2000はスリムな1Uブレードに、1ペタフロップスのAIコンピュート機能を搭載。世界No.1サーバのDell EMC PowerEdgeとの組み合わせでAI / ML環境で圧倒的なパフォーマンスを発揮し、DX時代を生き抜くPowerと価値を提供します。

|

|

|

|

4x GC200 IPUs ・1 PFLOP16.16 compute ・5,888 processor cores ・> 35,000 independent parallel threads |

Up to ~450GB Exchange Memory™ ・Up to 448GB Streaming MemoryTM DRAM ・3.6GB In-Processor-Memory™ |

IPU-Fabric for Compiled-In Networking ・IPU-Link – 4x 512Gbps for intra IPU-POD64 communication (2 Tbps) ・GW-Link – 2x 100Gbps Gateway-Links for inter IPU-POD64 communication (0.4 Tbps bidir.) ・IPU-Sync eliminating jitter for scale-out ・Host-Link – 2x 100Gbps ethernet to Poplar Server (0.4 Tbps bidir.) |

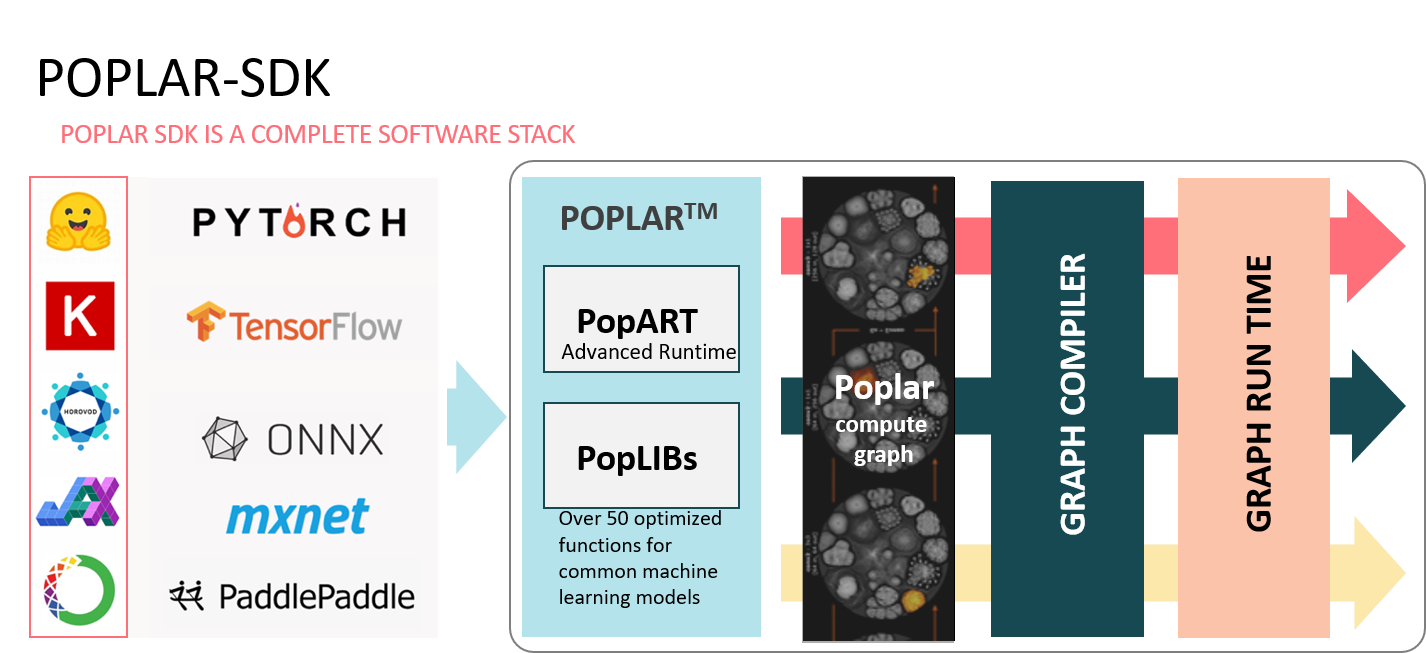

開発環境

| 標準的な機械学習フレームワークと完全に統合 | TensorFlow 1 & 2 サポート PyTorch サポート PopART™ (Poplar Advanced Runtime) 学習と推論をサポート Python/C++ model building plus ONNX model input |

Poplarは、TensorFlow、PyTorch、ONNX、PaddlePaddleなどの標準的なMLフレームワーク、およびOpen BMC、Redfish、Dockerコンテナや、Slurmおよび Kubernetesとのオーケストレーションなどをサポートしている為、容易に実用展開できます。

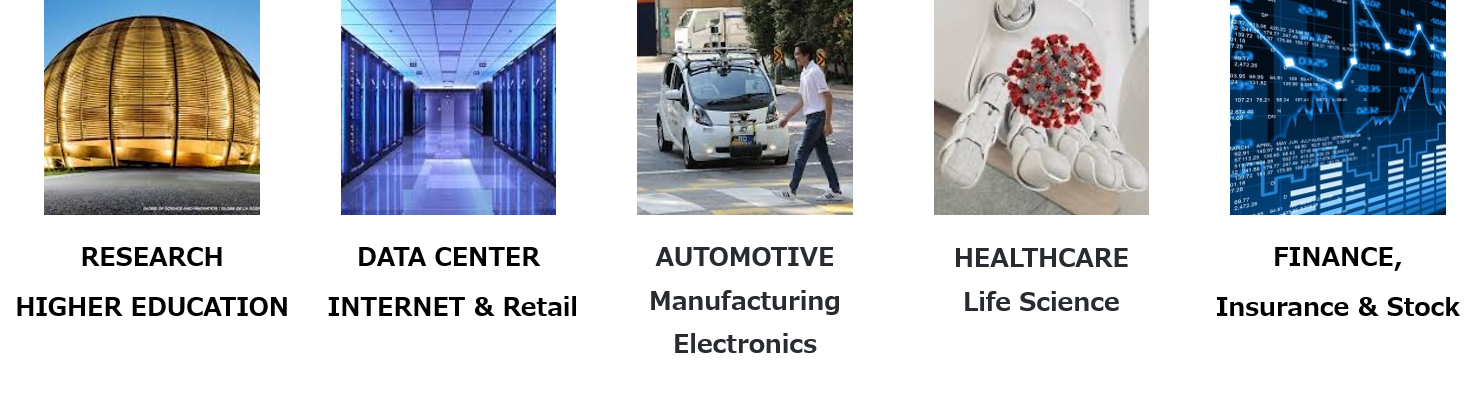

IPU マーケット

Graphcore IPUは多くの業界で導入され、高い性能を必要とするトレーニングと推論ワークロードで活用されています。

構成例

本番環境で導入実績豊富なPowerEdge R6525との組み合わせ例です。

業界屈指の高密度ハイパフォーマンスI/O

1Uサイズの筐体に最先端のネットワーク性能と帯域幅を提供するPCIe Gen4を搭載しIPU M-2000の性能を最大限引き出します。

高パフォーマンスかつ高電力効率

AMD EPYC 7742 ×2ソケットを搭載することにより、省電力でより高い性能を発揮します。