情報ガイドステーションメニュー

|

| PowerStoreでNVMe-oFを利用してみよう |

|

こんにちは。CTCの廣原です。

私は普段は、ストレージに関するプリセールスエンジニアの支援とフィールドエンジニアのバックサポートをしております。 普段は裏方中心の業務をしていますが、時々表に出てきてブログの記事を書かせていただくと思いますので、どうぞよろしくお願いします。 NVMe-oF(NVMe Over Fabrics)についてさて、早速ですが、初回はNVMe-oF(NVMe Over Fabrics)について少し書こうと思います。 日本国内では、ストレージのBlockアクセスはSCSIベースのSAN(FCまたはIP利用)がまだまだ中心ではありますが、NVMe-oFに対応した製品は徐々に世に出てきており、 数年をかけて少しずつ広まっていくでしょう。(日本は北米に比べると、新しい技術は2-3年程遅れて導入する傾向があります。) 今回はDellEMC PowerStore(以下、PowerStore)で、NVMe-oFをどのように構成するのかを触れていきたいと思います。 ※NVMeおよびNVMe-oFについての詳細は、一般公開されている情報がたくさんありますので、この記事では触れず、実際に設定してどんなものか見てみようという主旨で、以降の記事は書いています。 PowerStoreでは、以下のNVMe-oFに対応しています。 PowerStoreのNVMe-oF対応情報

※2022年4月現在で最新バージョンはPowerStore OS2.1.x.xです vSphereのNVMe-oF対応情報

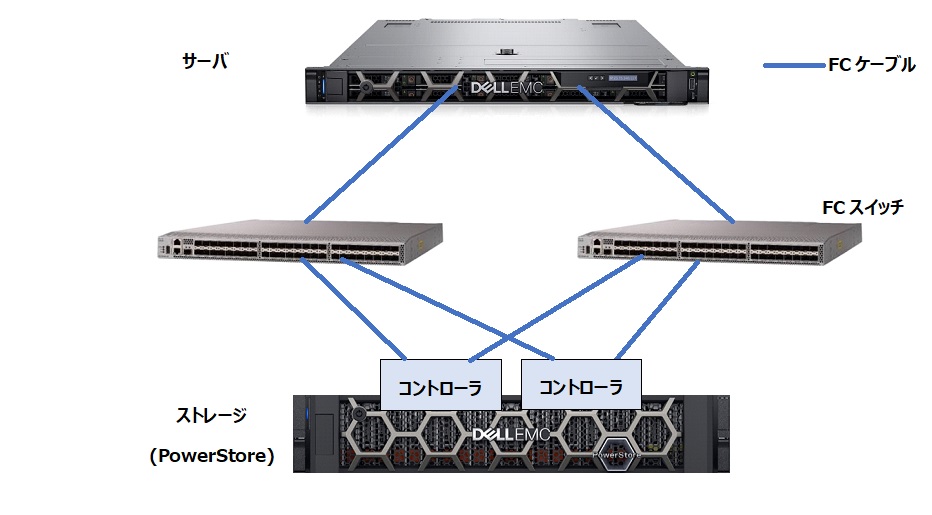

※厳密に書くと、7.0 u3でもプロトコルスタックに一部SCSIが入っており、完全ネイティブにはまだなっていません。 今回は導入というところをターゲットとしていますので、ESXi環境でのNVMe-oF(FC)を例示していきますが、NVMe-oFだからといっても、設定が複雑になることはなく、FCの設定とほとんど実施する内容は変わりません。 後述の”物理結線・SAN接続”の部分で記述しますが、H/Wの要件こそあれど、設定や考え方がガラリと変わるわけではないため、導入の敷居はそれほど高くはないと言えるでしょう。 構成にあたりヤルコト(概要)物理結線・SAN接続DAS(直結)構成はサポートされていないため、SAN構成(FCスイッチを経由しての接続)が必要です。 また、FCスイッチ側はNPIVを有効にしておくようにしてください。(PowerStore側はデフォルトでNPIVは有効) よくある、サーバ⇔FCスイッチ⇔ストレージを構成するものと同様(32Gb対応であれば基本的にOK、NVMe-oFのための専用機器は不要)です。 結線例  NVMe-oF構成の場合、ストレージ側のWWNがFCとNVMe-oFとで異なりますので、ゾーニングの際は注意してください。(似た番号になっていますので見間違わないように。) 物理結線・接続以降は以下のような流れで設定を行います。  設定概要

ESXi側設定(事前)– NQNがホスト側でまだない場合は生成します。設定例)

– HBA側の設定を行います。 【Qlogicの場合】 設定例)

確認例)

【Emulexの場合】 設定例)

確認例)

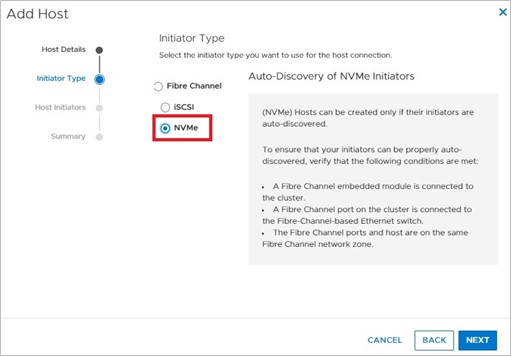

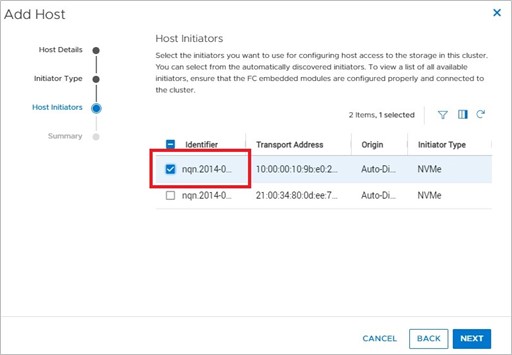

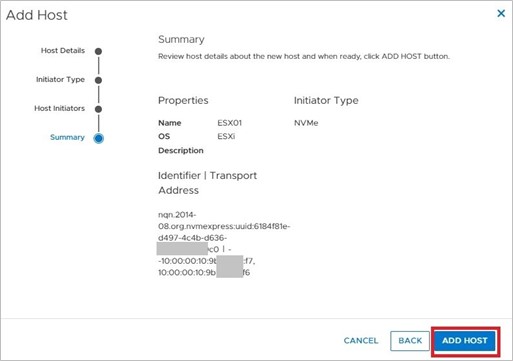

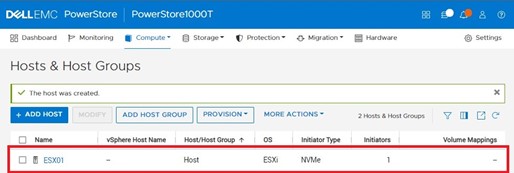

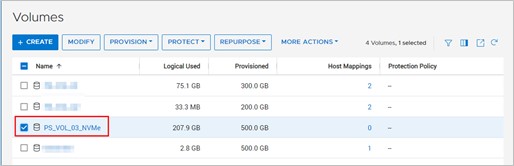

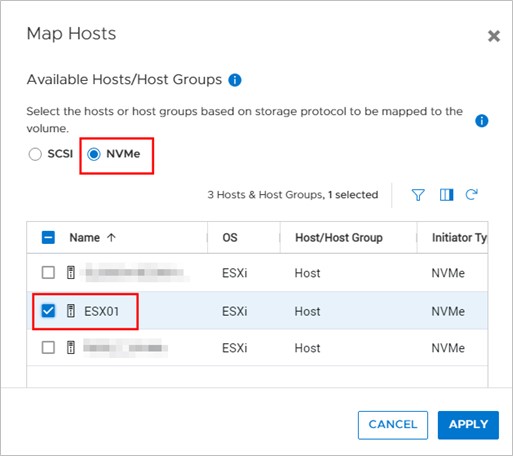

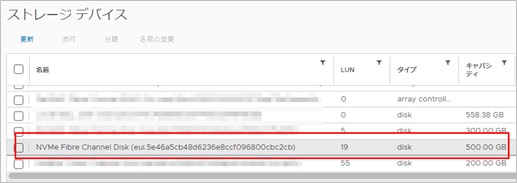

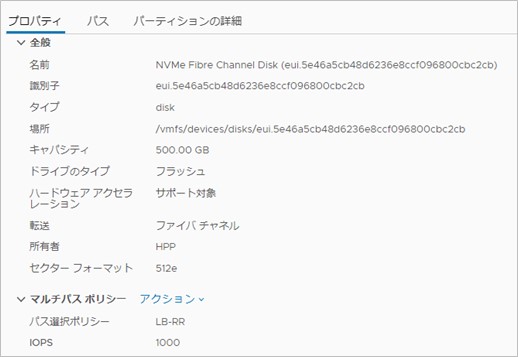

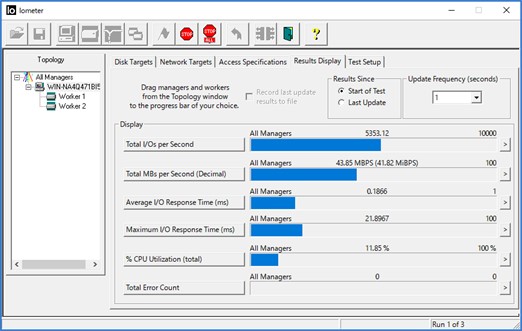

ストレージ設定:ホストの追加PowerStore Managerにログインし、Compute > Hosts & Host Groupの画面から[+ADD HOST]をクリックし、ホストを追加します。 ホストを作成する際に、イニシエータータイプからNVMeを選択します。  対象ホストのNQN(NVMe Qualified Name)を選択します。  設定内容を確認し[ADD HOST]すると、NVMeインターフェースのホストが作成されます。  追加されたホスト。  ストレージ設定:ボリュームのマップ作成されたボリュームをホストにマッピングします。 PowerStore Managerより、Storage > Volumes(またはVolume Groups)の画面から、[+CREATE]をクリック。  プロトコルのNVMeを選択し、マッピングするホストにチェックを入れてAPPLYします。  ストレージ(=PowerStore)の作業は以上です。 ESXi側設定(事後):データストア作成ここはvSphere(vCenter)の操作です。 vSphere Clientにて、ストレージの再スキャンを実施し、作成したボリュームがvSphereから見えることを確認します。  新しいデータストア作成を行います。  データストアが作成されていることを確認します。  ESXi側設定(事後):その他設定NVMe-oFに直接関係はありませんが、サーバ⇔ストレージ間のマルチパスポリシー設定や、IOのFrequency等の設定はHost Configuration Guideを参照し、必要に応じて設定を行ってください。 プロパティ)  パス)  さて、構成ができましたので、データストア上にVM(Windows)を1つ作成し、Iometerにて簡易テストを実施してみました。

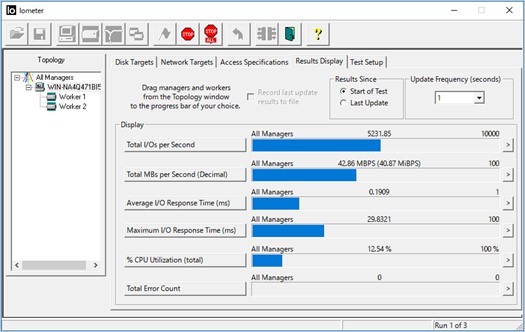

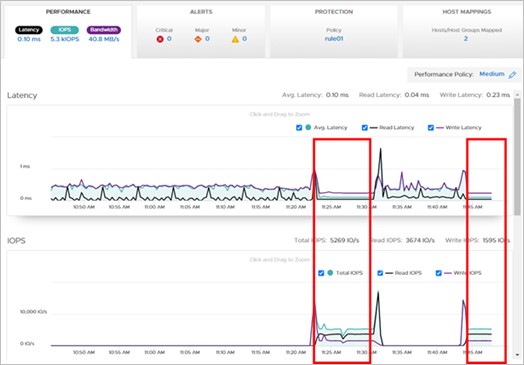

Iometer結果ウィンドウ:NVMe-oF構成)  PowerStore ManagerのPERFORMANCEウィンドウ:NVMe-oF構成) ※赤枠の部分がIometerで負荷をかけた部分です。  比較のため、NVMe-oF構成ではなく、FC構成でも同様の簡易テストを行いました。 (物理構成、テスト条件は同一です) Iometer結果ウィンドウ:FC構成)  PowerStore ManagerのPERFORMANCEウィンドウ:FC構成)  こちらを見ていただくとわかるとおり、NVMe-oF構成・FC構成ともに同様の値がでていることがわかります。(若干NVMe-oFが良い数値。) 1VMでの結果のためか、簡易テストではあまり差異は見られませんでしたが、多重化していった場合にNVMeのメリット(※)が出てくるが期待できます。このあたりはまた別途機会を設けていければと思います。 ※SCSIと比較してのIOキューイングの深さ、IOプロトコル変換オーバーヘッドの低減など 設定と簡易テストについて書いてみましたが、いかがでしたでしょうか。 設定自体は特に大きく難しくはないことはご理解いただけたと思いますので、まずは導入(検証)してみて、本番に利用できそうかを検討いただければ幸いです。 CTCではPowerStore検証機のお貸出し・検証のお手伝いが可能です。是非弊社(telbiz-product@ctc-g.co.jp)までご相談ください。

|

タグ: NVMe, PowerStore, ストレージ, パートナー