情報ガイドステーションメニュー

|

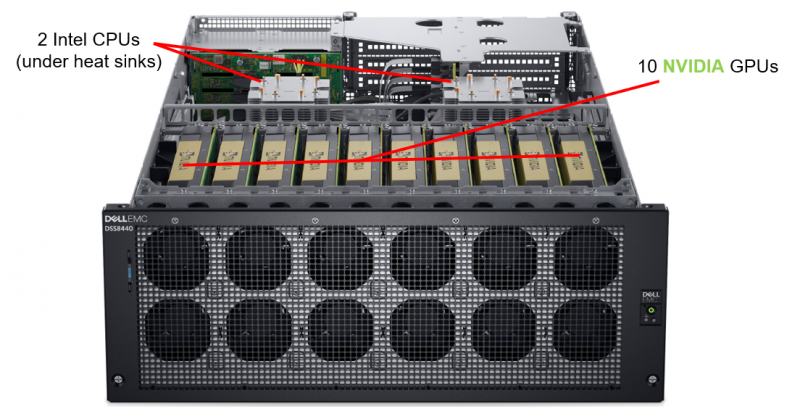

| 機械学習用モンスターマシン 「DSS 8440」 がついにリリース! |

|

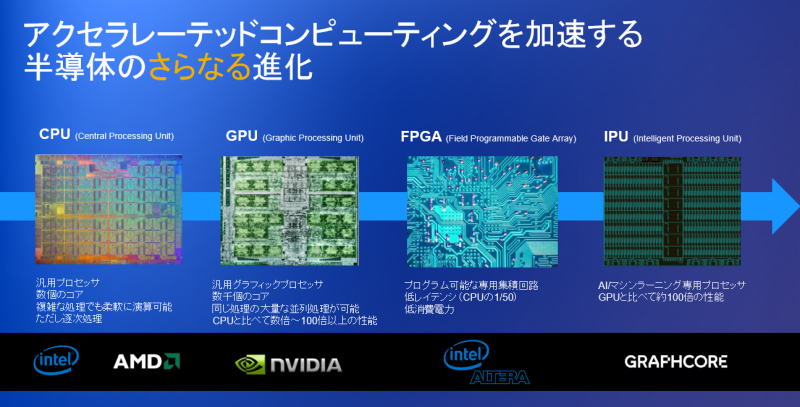

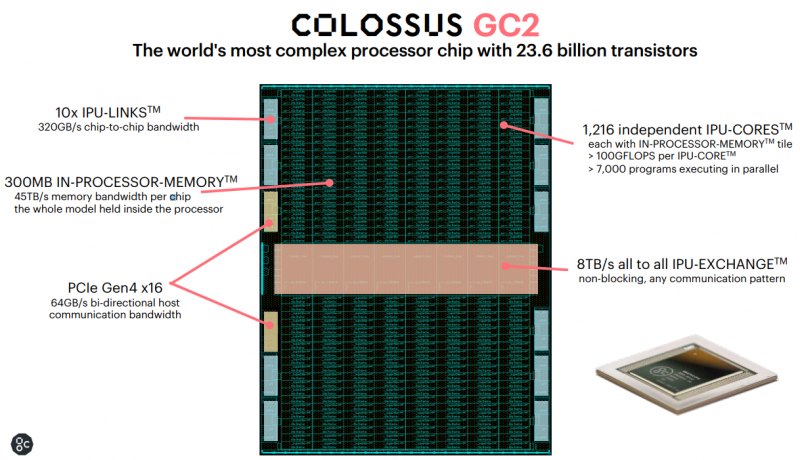

ディープラーニングを起爆剤として、日本でも空前のAIブームが到来しました。 当初は導入に対しての現実味がまだ薄かった、ハードルの高いものと捉えられているケースが多かったように思えます。 ですが、現在ではAIフレームワークや学習済みモデルがオープンソースとして流通してきて、そのハードルも下がってきており(今後もどんどん下がると思われる)、あらゆる分野で実用的なシステムとしての導入が進んできました。 そして、現在そのシステムインフラのコアになっているのが 「アクセラレーテッドコンピューティング」 となります。 「アクセラレーテッドコンピューティング」 とは、今までCPU中心で担ってきた処理をGPUやFPGAにオフロードすることにより、アプリケーションやワークロードを高速化する技術です。 今後、この技術はさらなる進化を遂げると予測されます。  この度、Dell EMCではAI(機械学習)専用ともいえるサーバー 「DSS 8440」 をリリースしました。 本製品の最大の特徴は画像認識、自然言語処理、気候モデルなどの機械学習で広く利用されているNVIDIA Tesla V100を 最大10基搭載可能 なところです。まさにモンスターマシン!?   シス テム全体でも機械学習に最適化されており、内蔵ストレージのボトルネック化を抑止する最大10本のNVMe SSDおよびSAS/SATA SSDを搭載可能なほか、高速なシャーシ間データ転送を実現するInfiniBandをサポートし、8本のPCIe x16スロットが利用可能など、ワークロードを高速化する特長を多数持ちます。 また、システムマネジメントに関してもiDRAC9が搭載されているので、PowerEdge Serverとほぼ同様の管理が可能です。 さらに本製品はGPUとは別に、英Graphcoreが開発するAI専用プロセッサのIPU(Intelligence Processing Unit)にも対応する予定です。(2019年後半予定)  このアクセラレーターカードには2つの「Colossus GC2」 IPUプロセッサが搭載されています。IPUプロセッサあたり1,216のIPU-Coreを搭載しており、1つのIPU-Coreの演算性能は100G(ギガ)Flops *となります。 * Flops = コンピュータが1秒間に処理可能な浮動小数点演算の回数を示す単位  Introducing Graphcore Presentation https://cdn2.hubspot.net/hubfs/729091/Introducing%20Graphcore’s%20Intelligence%20Processing%20Unit.pdf 「DSS 8440」 は このGraphcore C2アクセラレーターカードを 最大8枚搭載可能 な予定ですので、その演算性能は2P(ペタ)Flopsとなります。 First Reveal of Dell-Graphcore IPU Platform https://www.graphcore.ai/posts/first-reveal-of-dell-graphcore-ipu-platform ここまでくれば キング・オブ・モンスターマシン!? パートナーセールスエンジニア 中村 智宏

|