情報ガイドステーションメニュー

|

| AI環境でGPUリソースを有効活用 |

| Bitfusionの利用環境と方法 |

|

こんにちは。デル・テクノロジーズでAI関連ソリューションを担当している山口です。 皆さんVMworld、VMworld Japanは参加されましたでしょうか? VMworld Japanのオンデマンドセッション&資料ダウンロードは2021年1月29日までできるようなので、冬休みのお供にいいかもしれませね。 前回の記事ではBitfusionの概要についてお伝えいたしましたが、今回はBitfusionの用途や利用方法、今月リリースされたバージョン2.5のご紹介をいたします。

Bitfusionの利用用途

BitfusionはGPUをプール化し、Bitfusionクライアントから必要な時に必要なGPUリソースを利用できます。しかしBitfusionはすべてのAI / ML環境で利用できるというわけではありません。Bitfusionはリアルタイムアプリケーションや、CADなど画像の描写はターゲットとはしておらず、pythonで書かれたコードにGPUリソースを割り当ててAI/MLの学習を高速化するなど、バッチ的な利用方法になります。 また、現時点ではNVIDIA製GPU(V100やT4)が対象なので、FPGAなどは対象外となっています。 また、前回の記事でも紹介しましたがBitfusionはネットワーク経由でGPUリソースを利用するため、低遅延のネットワークが必要です。そのためインターネット越しでの利用は今時点では現実的ではなく、データセンター内での利用になるかと思います。インターネット越しでの利用は5Gネットワークや将来の6Gに期待ですね。 Bitfusionクライアントは2.0まではvSphere上のLinux仮想マシン(RHEL、Centos、Ubuntu)のみがサポートされていましたが、バージョン2.5で(個人的に)待望の拡張がされました!

Bitfusion 2.5

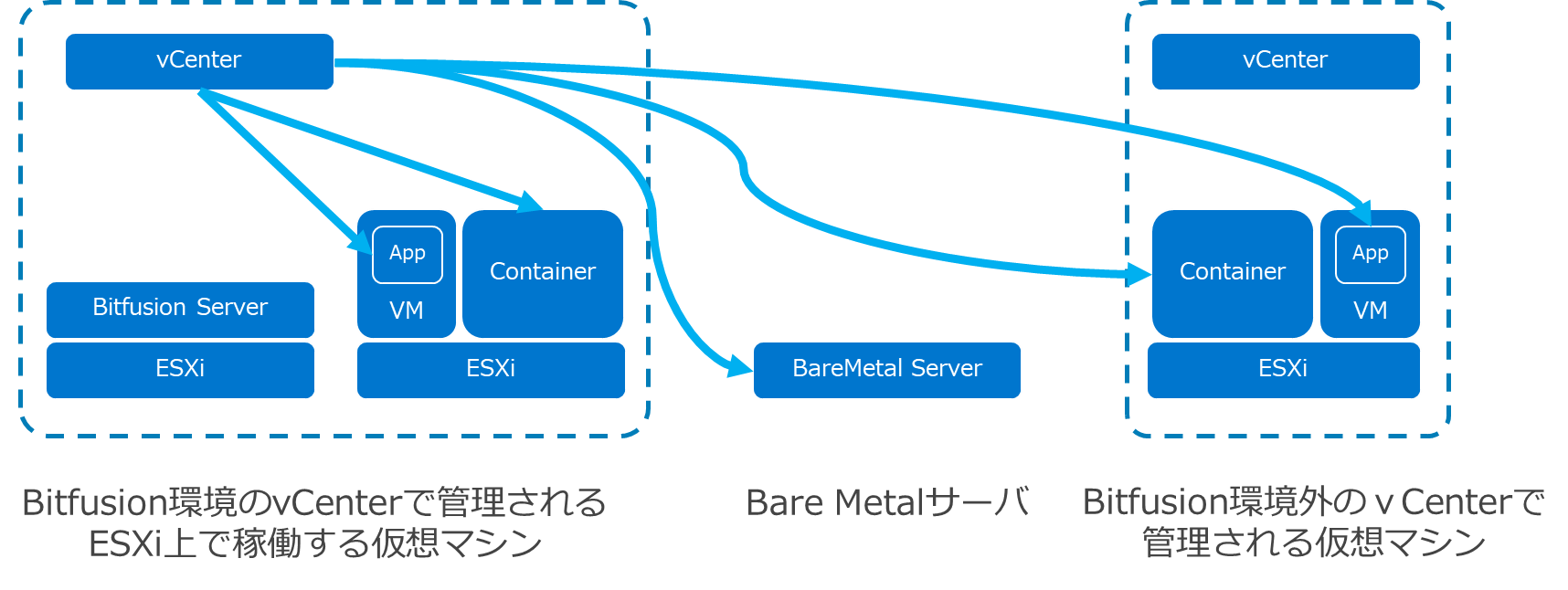

Bitfusionは2020年7月9日にGA版がリリースされて、8月に2.0.1、9月に2.0.2と3か月連続でアップデートがされ、11月5日に2.5がリリースされました。(リリースノートはこちら) NVIDIAドライバやCUDA、Tnesorflowなどのサポートバージョンが拡張されたのと、サポートされるBitfusionクライアントもUbuntu20やCentos8にも拡張されました。その中でも特に待っていたのがベアメタルクライアントのサポートです。リリースノートにはベアメタルクライアントと記載されていますが、Bitfusion環境外のvCenter環境で管理される仮想マシンでもBitfusionを利用することもできます。

ベアメタルクライアントにはvCenterで発行したTokenをクライアント側の特定のフォルダにコピーするだけでBitfusionを利用することができます。実際に試してみましたがとても簡単に導入することができました。

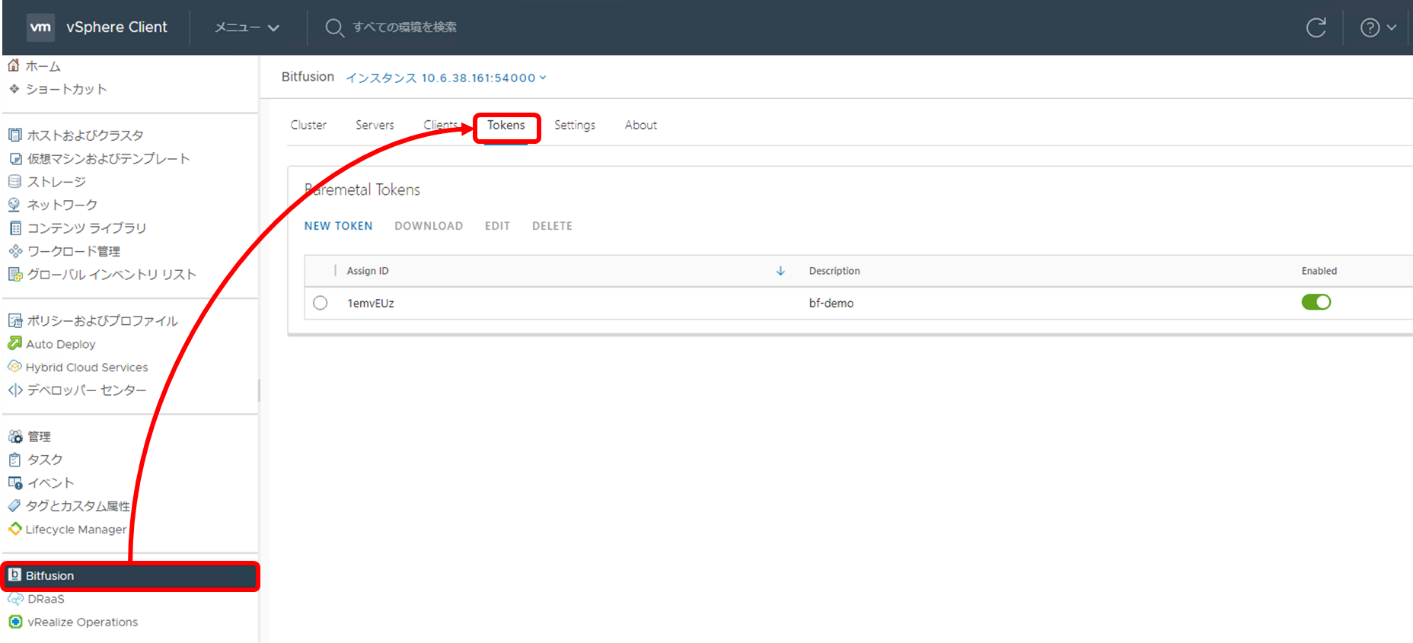

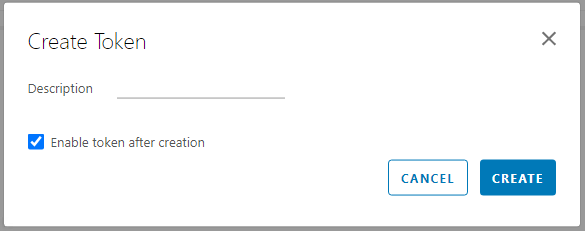

vCenterのBitfusionプラグイン画面にバージョン2.0ではなかった、Tokenタブができていて、NEW TOKENボタンでTokenを作成し、DOWNLOADボタンで作成したTokenをtar形式でダウンロードすることができます。Tokens作成も次の画面のようにDescriptionを入れるだけなのでとても簡単で、利用者に優しいつくりになっています。

Bitfusionの利用方法

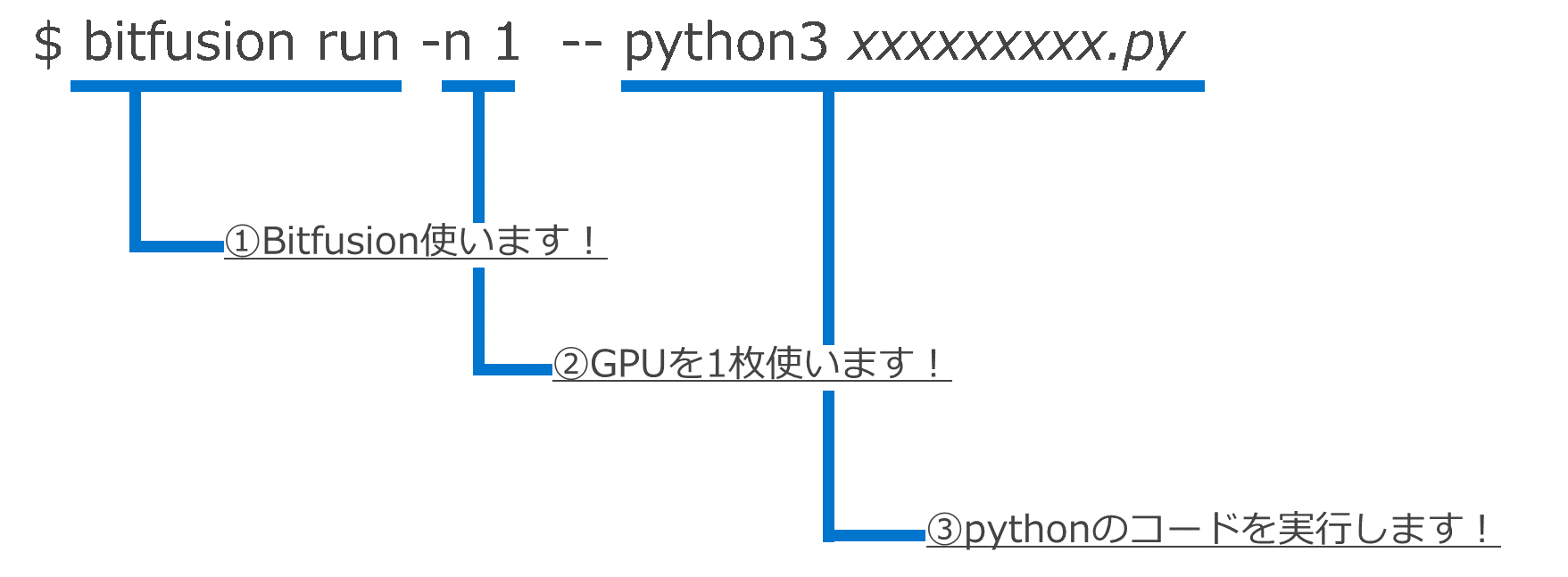

Bitfusionはいくつかの実行方法がありますが、Bitfusionクライアントが仮想マシンでも、ベアメタルでも実行方法に違いはありません。ここではPythonでかかれたコードを実行する際GPUリソースを割り当てて利用する場合の利用方法をご紹介します。 下のコマンド例はBitfusionクライアント側で、Pythonのコードを実行した例になります。

①のbitfusion run でBitfusionを利用することを宣言します。 ②の -n の引数で利用するGPUの枚数を指定します。 ③ではpython3のコマンドでpythonのコードを実行しています。 -nのほかにもGPUメモリを分割して利用する場合には-pや-mのオプションをつけて実行することによってメモリ分割ができます。 このようにBitfusionでコードを実行する際には、これまでpythonで実行していたコードを改変する必要もなく、実行していたコマンドに “bitfusion run -n GPU数”を加えるだけなので、簡単に利用できるのを理解いただけるのではないでしょうか。 今回はBitfusionの利用方法や最新バージョンの2.5についてご紹介いたしましたが、利用イメージをつかんでいただけたのではないでしょうか。 今後もアップデート情報や便利な利用方法など機会があれば紹介させていただきます。 Dell Technologies 製品本部 シニアシステムエンジニア 山口 泰亜 2020/11/30

関連記事はこちら情報ガイドステーション ソリューションページNVIDIA GPUとコンテナでAI環境作ってみた DockerでJupyterlab使ってコード実行してみた GPUのために設計されたサーバー 「PowerEdge C4140」 の実績と実力! AI環境でGPUリソースを有効活用 BitfusionでGPUをプール化(概要編) AI環境でGPUリソースを有効活用 Bitfusionの利用環境と方法 AI環境でGPUリソースを有効活用 BitfusionでGPUのメモリ分割 AI環境でGPUリソースを有効活用 他ソフトウェアと連携してBitfusionをもっと便利に AI環境でGPUリソースを有効活用 ベアメタルサーバもBitfusionで高速化! HPC and AI Innovation Labのご紹介 サンディエゴスーパーコンピューターセンターの新スパコン 「Expanse」 にDellEMCのAMDサーバーが採用!

|