情報ガイドステーションメニュー

|

| GPUのために設計されたサーバー |

| 「PowerEdge C4140」 の実績と実力! |

|

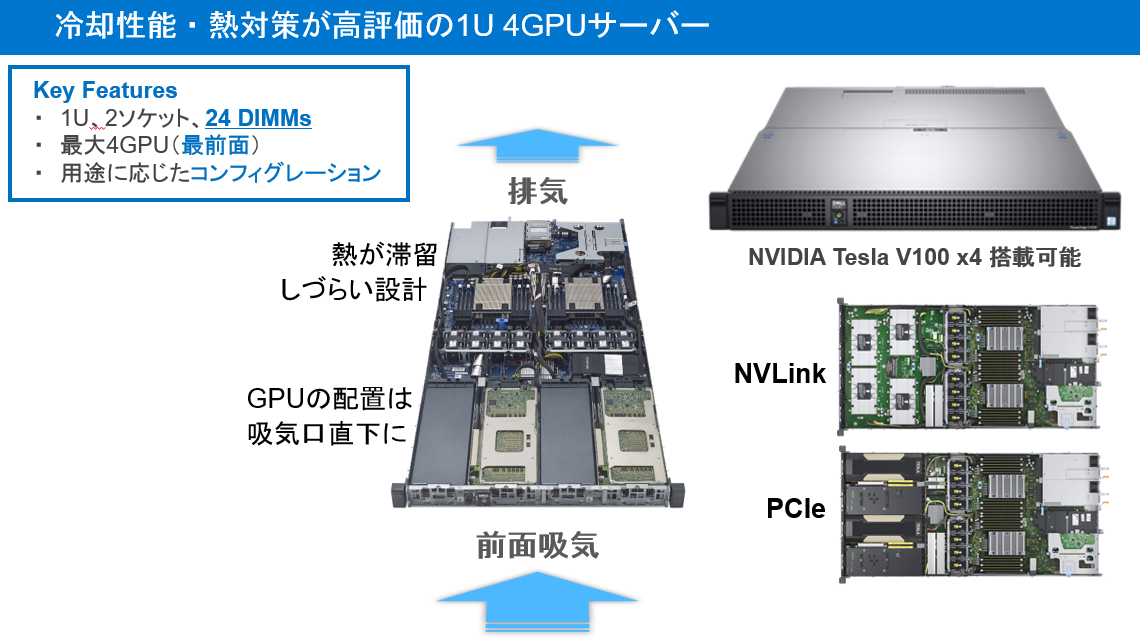

毎日のように新しい研究結果やソリューション開発がされ、着々と身近な存在になりつつあるAIですが、その発展において今やGPUは切り離せない存在になってきております。 エンタープライズインフラ市場においてもGPUが搭載されたサーバーを採用するケースは増えており、今後も右肩上がりに成長すると予測されます。 (IDCではこの市場を「アクセラレーテッドコンピューティング」と定義しており、何故GPUサーバーが必要かについては「GPUサーバー選定ガイド」を参照。) Dell EMCではGPUの為に設計されたと言っても過言ではない 「PowerEdge C4140」 というサーバーを展開しております。 この 「PowerEdge C4140」 は 1U でありながら NVIDIA V100シリーズを 最大4基搭載 可能なサーバーとなっています。また、搭載されるGPUをサーバーの最前面に搭載することで冷却効率を高め、GPUの性能を最大限に発揮する 「GPU最前面冷却」 設計となっております。

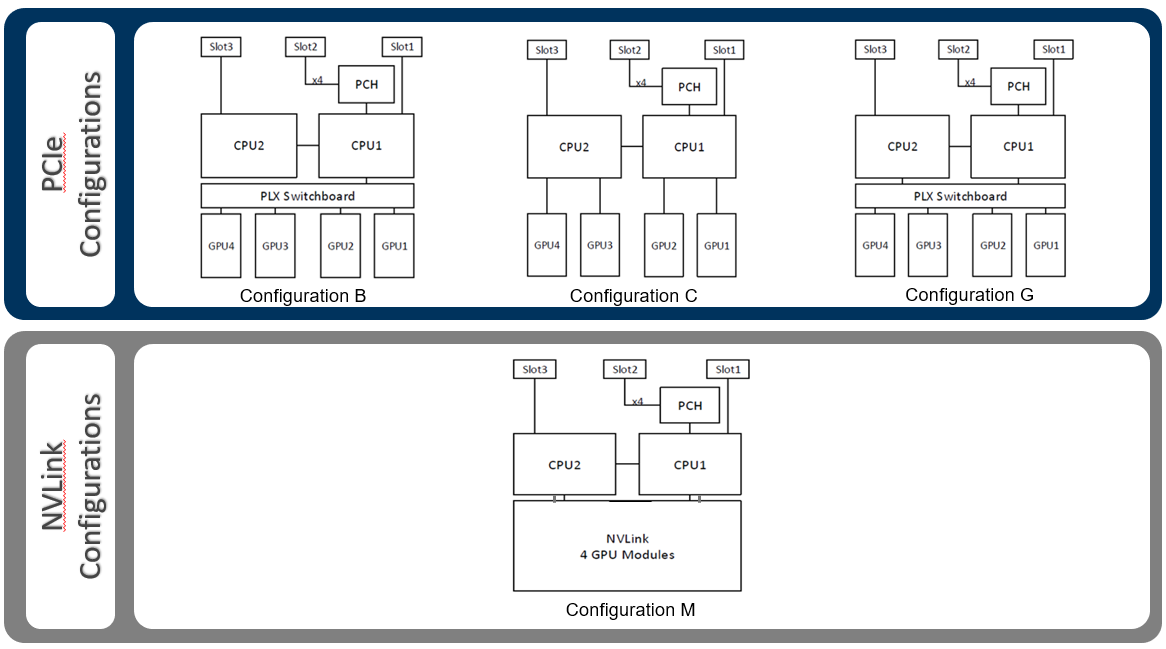

また、このサーバーのもう一つの特徴として、様々なワークロードに対応するために複数のコンフィグレーションを用意。PCIe構成と、NVLink構成の両方に対応します。

例えば、Deep Learning(学習)であればConfig M、Financial Services(モンテカルロ法など)はConfig Cなど、ワークロードにあわせてサーバー構成を選択する事が可能です。まさにGPUにために設計されたサーバーとなります。 また、システムマネジメントに関してもiDRAC9が搭載されているので、PowerEdge Server同様の管理が可能です。 この 「PowerEdge C4140」 の冷却性能が如何に優れているかを証明する国内事例を以下に紹介します。株式会社ロゼッタ様の事例です。

株式会社ロゼッタ様ではディープラーニングを活用した機械翻訳サービス(各専門分野に特化たした機会翻訳)を提供しており、その翻訳精度は95%(これはプロの翻訳家レベルだそうです。すごい!)にまで達したそうです。 その計算を行うサーバーとして 「PowerEdge C4130/C4140」 を採用頂き、ディープラーニングの学習速度においては既存システムの3倍向上し、熱暴走や製品劣化が懸念されていた既存システムより20度以上熱を下げることを実現しました。 ※ディープラーニングの学習速度のパフォーマンスについては、MLPerfでも実証されています。詳細については 「機械学習(ディープラーニング)用の業界標準ベンチマーク 「MLPerf」 が登場!」 を参照下さい。 次に紹介するのが海外からの大規模事例、Eni 社の事例となります。 Eni 社、スーパーコンピューターの GPU を倍増し、演算能力を 52 PFLOPS に強化 https://blogs.nvidia.co.jp/2019/11/22/eni-gpus-supercomputer/ この 「HPC5」 と名付けられた新しいシステムは、7280基の NVIDIA V100 GPU が搭載され、52PFLOPSの倍精度浮動小数点処理が可能となります。 そして、このシステムを構成するサーバーが 1,820台の 「PowerEdge C4140」 で構成されており、それぞれに4つの NVIDIA V100 GPU と 2つのIntel CPUが搭載されています。また、これらのサーバーは、200 Gb/sで動作するMellanox InfiniBand HDR ネットワークで接続されています。 このスーパーコンピューター(スパコン)が稼働されれば、Top500のランキングに当てはめても世界最速の産業用スパコンになると思われます。 このように市場でも高い評価を頂き、続々と国内外で採用が広がる 「PowerEdge C4140」 は今後も大注目のPowerEdge Serverとなります! パートナーセールスエンジニア 中村 智宏 関連記事はこちら情報ガイドステーション ソリューションページNVIDIA GPUとコンテナでAI環境作ってみた DockerでJupyterlab使ってコード実行してみた GPUのために設計されたサーバー 「PowerEdge C4140」 の実績と実力! AI環境でGPUリソースを有効活用 BitfusionでGPUをプール化(概要編) AI環境でGPUリソースを有効活用 Bitfusionの利用環境と方法 AI環境でGPUリソースを有効活用 BitfusionでGPUのメモリ分割 AI環境でGPUリソースを有効活用 他ソフトウェアと連携してBitfusionをもっと便利に AI環境でGPUリソースを有効活用 ベアメタルサーバもBitfusionで高速化! HPC and AI Innovation Labのご紹介 サンディエゴスーパーコンピューターセンターの新スパコン 「Expanse」 にDellEMCのAMDサーバーが採用!

|